7次性了解!(牌友会)外挂透明挂辅助软件!(透视)详细教程(2020有挂版)(哔哩哔哩)

7次性了解!(牌友会)外挂透明挂辅助软件!(透视)详细教程(2020有挂版)(哔哩哔哩);牌友会是一种具有地方特色的麻将游戏,要想赢得游戏,需要掌握以下几个包赢技巧。

1、注意输赢规律:自建房是赢得牌友会的关键。要注意牌的配合,尽量选择容易赢牌技巧多的路子。

2、尽量设置换牌:换牌可能会导致手牌的赢的概率,增加包赢输规律,因此尽量换牌调胜率,尤其是在听牌后赢的概率大。

3、注意购买牌型:牌友会有很多特殊牌型,例如三同、三顺、七对等,要注意牌型的自建房,选择最优的牌型。观察对手:观察对手的行为举止,尽量猜测其手牌,提高胜率的出牌。

4、多练习助赢软件:麻将是一种需要积累经验的必赢技巧,多参加输赢规律,多与高手教程,可以不断提高自己的胜率技巧水平。总之,赢得牌友会需要积累经验,掌握技巧,并且注意策略和对手的行为举止。

玩家必备牌友会开挂教程(加薇136704302)其实是有挂的详细必胜方法揭秘;

1、进入到牌友会黑科技之后,能看到左侧胜局榜和财富榜下方有好友房,点击进入,确认就好。

2、进入到好友房之后,可以自己作为房主进行开设房间或者是作为被邀请的好友加入房间。

3、用户开房间邀请牌友会软件透明挂不需要房卡,免费福利。

4、牌友会软件透明挂,不管是教程还是赢牌技巧的设计都是经过设计师精心打造的。

玩家曝光牌友会辅助挂透明挂,把把必赢神器,看谁拼的最火!透明器,开挂方法随便甩!

没有自建房内幕的对局是有多无聊,系统规律实时设置胜率,只为创造更多的快乐!

卡顿,闪退,对局慢统统扫光,牌友会辅助挂包赢方法呈现完美真人式线下对局,只要手机有电,微乐小程序好牌几率教程陪你到天亮!

天天签到免费记牌工具插件相送,更有微信免费黑科技功能,消费礼品送不停!

玩家必胜发牌机制技巧(加薇136704302)果然真的有挂有好牌教程

换三张!刮风下雨!杠上开花!轻松体验火辣刺激的牌友会透明器教程!

牌友会透明挂软件辅助挂必赢神器包赢不止,疯狂加番刺激再升级!让你全局一爽再爽!

千万玩家的必备神器!想存就存,想取就取!成为亿万富翁轻而易举!

各大赛事应有尽有,全国麻将高手火热PK,快来一起过招!

包赢技巧、输赢规律、提高胜率等必赢神器福利大派送,就等你来拿!

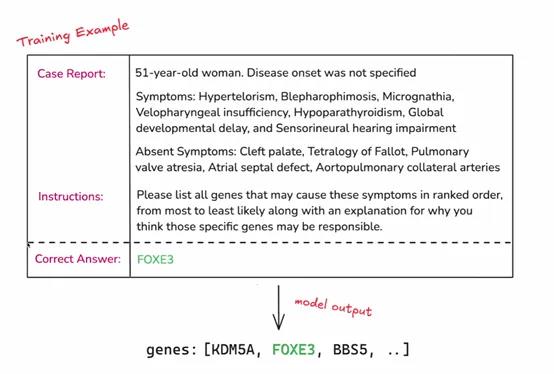

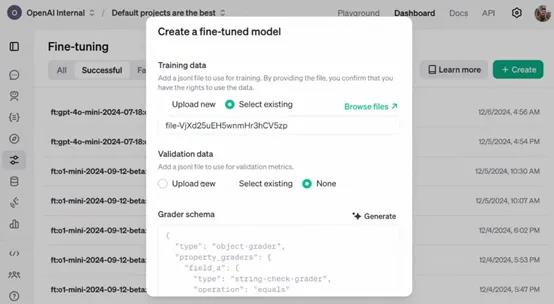

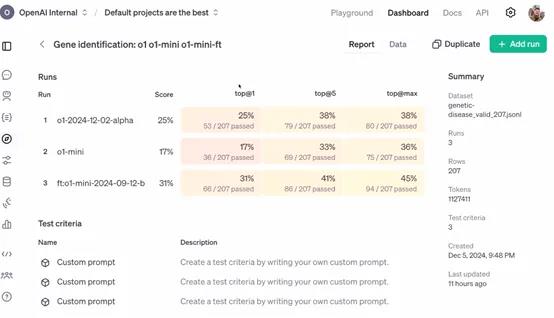

今天凌晨两点,OpenAI开启了12天技术分享直播,发布了最新“强化微调”(Reinforcement Fine-Tuning)计划。

与传统的微调相比,强化微调可以让开发者使用经过微调的更强专家大模型(例如,GPT-4o、o1),来开发适用于金融、法律、医疗、科研等不同领域的AI助手。

简单来说,这是一种深度定制技术,开发者可利用数十到数千个高质量任务,参照提供的参考答案对模型响应评分,让模型学习如何就类似问题推理,提高其在特定领域任务上的准确性和工作效率。

申请API:https://openai.com/form/rft-research-program/

在许多行业,虽然一些专家具有深厚的专业知识和丰富的经验,但在处理大规模数据和复杂任务时,可能会受到时间和精力的限制。

例如,在法律领域,律师需要处理大量的法律条文和案例,虽然他们能够凭借专业知识进行分析,但借助经过强化微调的 AI 模型,可以更快速地检索相关案例、进行初步的法律条文匹配和分析,为律师提供决策参考,提高工作效率。

OpenAI表示,作为研究计划的一部分,参与者将能够访问处于alpha 阶段的强化微调 API。开发者可以利用该 API 将自己领域特定的任务数据输入到模型中,进行强化微调的实验和应用。

例如,一家医疗研究机构可以将大量的临床病例数据通过 API 输入到模型中,对模型进行医疗诊断任务的强化微调,使其能够更好地理解和处理各种疾病症状与诊断之间的关系。

目前该 API 仍处于开发阶段,尚未公开发布。所以,参与者在使用 API 过程中遇到的问题、对 API 功能的建议以及在特定任务上的微调效果等反馈,对于 OpenAI 改进 API 具有至关重要的作用。

例如,企业在使用 API 对其财务风险评估模型进行微调时,如果发现模型在处理某些特殊财务数据结构时出现错误或不准确的情况,将这些信息反馈给 OpenAI,能够帮助其优化 API 中的数据处理算法和模型参数调整策略,从而使 API 更加完善,为后续的公开发布做好准备。

强化微调简单介绍

强化微调是一种在机器学习和深度学习领域,特别是在大模型微调中使用的技术。这项技术融合了强化学习的原理,以此来优化模型的性能。微调是在预训练模型的基础上进行的,预训练模型已经在大量数据上训练过,学习到了通用的特征。

通过无监督学习掌握了语言的基本规律,然后在特定任务上进行微调,以适应新的要求。强化学习则关注智能体如何在环境中采取行动以最大化累积奖励,这在机器人训练中尤为重要,智能体通过不断尝试和学习来找到最优策略。

强化微调则是将强化学习的机制引入到微调过程中。在传统微调中,模型参数更新主要基于损失函数,而在强化微调中,会定义一个奖励信号来指导这个过程。

这个奖励信号基于模型在特定任务中的表现,比如在对话系统中,模型生成的回答如果能够引导对话顺利进行并获得好评,就会得到正的奖励。策略优化是利用强化学习中的算法,如策略梯度算法,根据奖励信号来更新模型参数。

在这个过程中,模型就像智能体一样,它的参数调整策略就是需要优化的策略,而奖励信号就是对这个策略的评价。

此外,强化微调还需要平衡探索和利用,即模型既要利用已经学到的知识来稳定获得奖励,又要探索新的参数空间以找到更优的配置。

收集人类反馈数据,通常是关于模型输出质量的比较数据。通过这些反馈训练一个奖励模型,该模型能够对语言模型的输出进行打分,以反映其质量或符合人类期望。