Linux网络编程---UDP服务器

一、TCP通信和UDP通信各自的优缺点

TCP:面向连接的,可靠数据包传输。对于不稳定的网络层,采取完全弥补的通信方式。 丢包重传。

优点:稳定(数据流量稳定、速度稳定、顺序)

缺点:传输速度慢。相率低。开销大。使用场景:数据的完整型要求较高,不追求效率。

大数据传输、文件传输。

UDP:无连接的,不可靠的数据报传递。对于不稳定的网络层,采取完全不弥补的通信方式。 默认还原网络状况优点:传输速度块。相率高。开销小。

缺点:不稳定(数据流量。速度。顺序。)

使用场景:对时效性要求较高场合。稳定性其次。游戏、视频会议、视频电话。腾讯、华为、阿里 --- 应用层数据校验协议,弥补udp的不足。

二、UDP通信(无三次握手四次挥手)

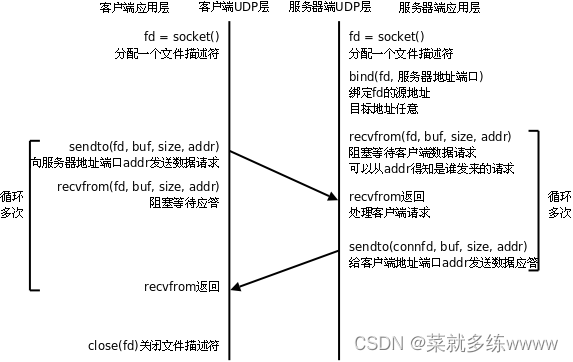

1.UDP的处理模型

2.UDP实现的C/S模型

相对TCP来说, accept()和connect()被舍弃;

recv()和send()只能用于TCP,在UDP中使用recvfrom和sendto来替代read、write

server端:

1. lfd = socket(AF_INET,SOCK_DGRAM,0) 由SOCK_STREAM 改为了 SOCK_DGRAM

2. bind(lfd,地址结构,地址结构大小)

3. listen() --> 可有可无

4. while(1){ read(cfd,buf,sizeof)-->被替换为-->recvfrom() write()-->被替换为-->sendto() }

5. close()

client端:

1. confd = socket(AF_INET,SOCK_DGRAM,0)

2. sendto(服务器的地址结构,地址结构大小)

3. recvfrom()读回新数据

4. close()

3.recvfrom和sendto函数

ssize_t recvfrom(int sockfd, void *buf, size_t len, int flags,struct sockaddr *src_addr, socklen_t *addrlen);

参数:

sockfd: 套接字

buf:缓冲区地址

len:缓冲区大小

flags: 0

src_addr:(struct sockaddr *)&addr 传出。 对端的地址结构

addrlen:传入传出。

返回值:

成功:接收数据字节数

失败:-1 errno

0: 对端关闭

ssize_t sendto(int sockfd, const void *buf, size_t len, int flags,const struct sockaddr *dest_addr, socklen_t addrlen);

参数:

sockfd: 套接字

buf:存储数据的缓冲区

len:数据长度

flags: 0

src_addr:(struct sockaddr *)&addr 传入。 目标地址结构

addrlen:地址结构长度。

返回值:

成功:写出数据字节数。

失败: -1, errno

借助TCP的CS模型改写UDP的CS模型,代码实现:

server.c

#include #include #include #include #include #define SERV_PORT 8000 int main(void) { struct sockaddr_in serv_addr, clie_addr; socklen_t clie_addr_len; int sockfd; char buf[BUFSIZ]; char str[INET_ADDRSTRLEN]; int i, n; sockfd = socket(AF_INET, SOCK_DGRAM, 0); bzero(&serv_addr, sizeof(serv_addr)); serv_addr.sin_family = AF_INET; serv_addr.sin_addr.s_addr = htonl(INADDR_ANY); serv_addr.sin_port = htons(SERV_PORT); bind(sockfd, (struct sockaddr *)&serv_addr, sizeof(serv_addr));//无效,该行可注释 printf("Accepting connections ...\n"); while (1) { clie_addr_len = sizeof(clie_addr); n = recvfrom(sockfd, buf, BUFSIZ,0, (struct sockaddr *)&clie_addr, &clie_addr_len); if (n == -1) perror("recvfrom error"); printf("received from %s at PORT %d\n", inet_ntop(AF_INET, &clie_addr.sin_addr, str, sizeof(str)), ntohs(clie_addr.sin_port)); for (i = 0; i < n; i++) buf[i] = toupper(buf[i]); n = sendto(sockfd, buf, n, 0, (struct sockaddr *)&clie_addr, sizeof(clie_addr)); if (n == -1) perror("sendto error"); } close(sockfd); return 0; } client.c

#include #include #include #include #include #define SERV_PORT 8000 int main(int argc, char *argv[]) { struct sockaddr_in servaddr; int sockfd, n; char buf[BUFSIZ]; sockfd = socket(AF_INET, SOCK_DGRAM, 0); bzero(&servaddr, sizeof(servaddr)); servaddr.sin_family = AF_INET; inet_pton(AF_INET, "127.0.0.1", &servaddr.sin_addr); servaddr.sin_port = htons(SERV_PORT); bind(sockfd, (struct sockaddr *)&servaddr, sizeof(servaddr)); while (fgets(buf, BUFSIZ, stdin) != NULL) { n = sendto(sockfd, buf, strlen(buf), 0, (struct sockaddr *)&servaddr, sizeof(servaddr)); if (n == -1) perror("sendto error"); n = recvfrom(sockfd, buf, BUFSIZ, 0, NULL, 0); //NULL:不关心对端信息 if (n == -1) perror("recvfrom error"); write(STDOUT_FILENO, buf, n); } close(sockfd); return 0; } 三、本地套接字通信

IPC: pipe、fifo、mmap、信号、本地套接字(domain)--- CS模型

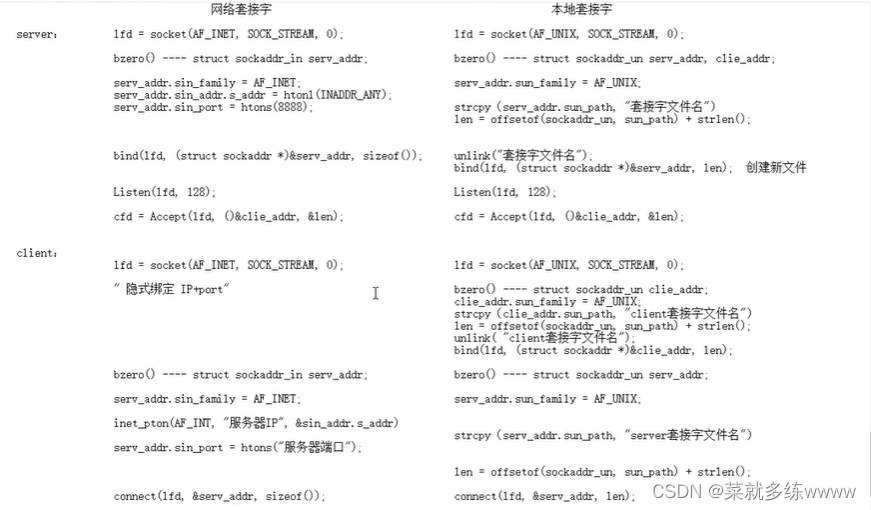

对比网络编程 TCP C/S模型,注意以下几点:

1. int socket(int domain, int type, int protocol); 参数 domain:AF_INET --> AF_UNIX/AF_LOCAL

type: SOCK_STREAM/SOCK_DGRAM 都可以。

2. 地址结构: sockaddr_in --> sockaddr_un

- struct sockaddr_in srv_addr; --> struct sockaddr_un srv_adrr;

- srv_addr.sin_family = AF_INET; --> srv_addr.sun_family = AF_UNIX;

- srv_addr.sin_port = htons(8888); strcpy(srv_addr.sun_path, "srv.socket")

- srv_addr.sin_addr.s_addr = htonl(INADDR_ANY); len = offsetof(struct sockaddr_un, sun_path) + strlen("srv.socket");

bind(fd, (struct sockaddr *)&srv_addr, sizeof(srv_addr)); --> bind(fd, (struct sockaddr *)&srv_addr, len);

3. bind()函数调用成功,会创建一个 socket。因此为保证bind成功,通常我们在 bind之前, 可以使用 unlink("srv.socket");

4. 客户端不能依赖 “隐式绑定”。并且应该在通信建立过程中,创建且初始化2个地址结构:

- client_addr --> bind()

- server_addr --> connect();

代码实现:

server.c

#include #include #include #include #include #include #include #include #include #include "wrap.h" #define SERV_ADDR "serv.socket" int main(void) { int lfd, cfd, len, size, i; struct sockaddr_un servaddr, cliaddr; char buf[4096]; lfd = Socket(AF_UNIX, SOCK_STREAM, 0); bzero(&servaddr, sizeof(servaddr)); servaddr.sun_family = AF_UNIX; strcpy(servaddr.sun_path, SERV_ADDR); len = offsetof(struct sockaddr_un, sun_path) + strlen(servaddr.sun_path); /* servaddr total len */ unlink(SERV_ADDR); /* 确保bind之前serv.sock文件不存在,bind会创建该文件 */ Bind(lfd, (struct sockaddr *)&servaddr, len); /* 参3不能是sizeof(servaddr) */ Listen(lfd, 20); printf("Accept ...\n"); while (1) { len = sizeof(cliaddr); //AF_UNIX大小+108B cfd = Accept(lfd, (struct sockaddr *)&cliaddr, (socklen_t *)&len); len -= offsetof(struct sockaddr_un, sun_path); /* 得到文件名的长度 */ cliaddr.sun_path[len] = '\0'; /* 确保打印时,没有乱码出现 */ printf("client bind filename %s\n", cliaddr.sun_path); while ((size = read(cfd, buf, sizeof(buf))) > 0) { for (i = 0; i < size; i++) buf[i] = toupper(buf[i]); write(cfd, buf, size); } close(cfd); } close(lfd); return 0; } client.c

#include #include #include #include #include #include #include #include #include #include #include "wrap.h" #define SERV_ADDR "serv.socket" #define CLIE_ADDR "clie.socket" int main(void) { int cfd, len; struct sockaddr_un servaddr, cliaddr; char buf[4096]; cfd = Socket(AF_UNIX, SOCK_STREAM, 0); bzero(&cliaddr, sizeof(cliaddr)); cliaddr.sun_family = AF_UNIX; strcpy(cliaddr.sun_path,CLIE_ADDR); len = offsetof(struct sockaddr_un, sun_path) + strlen(cliaddr.sun_path); /* 计算客户端地址结构有效长度 */ unlink(CLIE_ADDR); Bind(cfd, (struct sockaddr *)&cliaddr, len); /* 客户端也需要bind, 不能依赖自动绑定*/ bzero(&servaddr, sizeof(servaddr)); /* 构造server 地址 */ servaddr.sun_family = AF_UNIX; strcpy(servaddr.sun_path, SERV_ADDR); len = offsetof(struct sockaddr_un, sun_path) + strlen(servaddr.sun_path); /* 计算服务器端地址结构有效长度 */ Connect(cfd, (struct sockaddr *)&servaddr, len); while (fgets(buf, sizeof(buf), stdin) != NULL) { write(cfd, buf, strlen(buf)); len = read(cfd, buf, sizeof(buf)); write(STDOUT_FILENO, buf, len); } close(cfd); return 0; } 四、本地套接字和网络套接字的对比

五、通信总结

Linux网络编程本质就是实现服务端和客户端的通信传输,而Linux系统编程也有讲过本地进程间的通信,所以总结一下各种通信的方式,以免混淆;

本地通信:

- pipe(管道):实现了有血缘关系进程间的通信

- fifo:可用于非血缘关系进程间的通信

- mmap内存映射:上面两个的功能它都可以实现

- 信号:信号量

- 本地套接字:socket(),参数 domain:AF_UNIX/AF_LOCAL

网络通信:

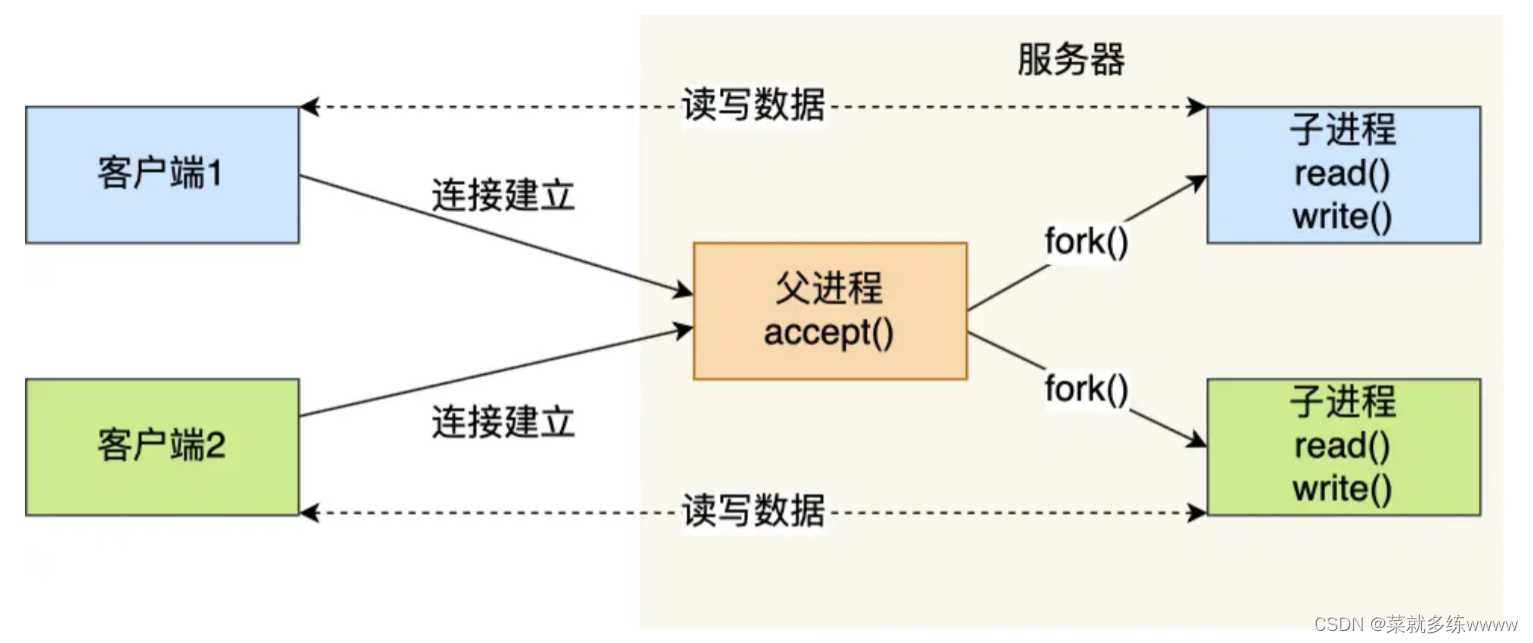

- 多进程:当服务器与客户端 TCP 完成连接后,通过 fork()函数创建进程,然后将「已连接 Socket」的文件描述符传递给进程函数,接着在进程里和客户端进行通信,从而达到并发处理的目的。

- 多线程:当服务器与客户端 TCP 完成连接后,通过 pthread_create() 函数创建线程,然后将「已连接 Socket」的文件描述符传递给线程函数,接着在线程里和客户端进行通信,从而达到并发处理的目的。

为每个请求分配一个进程/线程的方式不合适,那有没有可能只使用一个进程来维护多个 Socket 呢?答案是有的,那就是 I/O 多路复用(多路I/O转接)技术:

- select/poll:存在缺点--当客户端越多,也就是 Socket 集合越大,Socket 集合的遍历和拷贝会带来很大的开销,因此也很难应对 C10K。

- epoll:很好的解决了 select/poll 的问题

epoll 在内核里使用「红黑树」来关注进程所有待检测的 Socket,红黑树是个高效的数据结构,增删改一般时间复杂度是 O(logn),通过对这棵黑红树的管理,不需要像 select/poll 在每次操作时都传入整个 Socket 集合,减少了内核和用户空间大量的数据拷贝和内存分配。

epoll 使用事件驱动的机制,内核里维护了一个「链表」来记录就绪事件,只将有事件发生的 Socket 集合传递给应用程序,不需要像 select/poll 那样轮询扫描整个集合(包含有和无事件的 Socket ),大大提高了检测的效率。