内网服务器Python环境配置手册

使用U盘的文件传输

1. 在外部可联网机器上下载目标资源保存到移动U盘上

2. 将U盘移动到内网服务器上

3. 执行以下命令移动U盘中的目标资源至内网服务器上

(1)检查内网服务器上是否识别到U盘

使用命令:

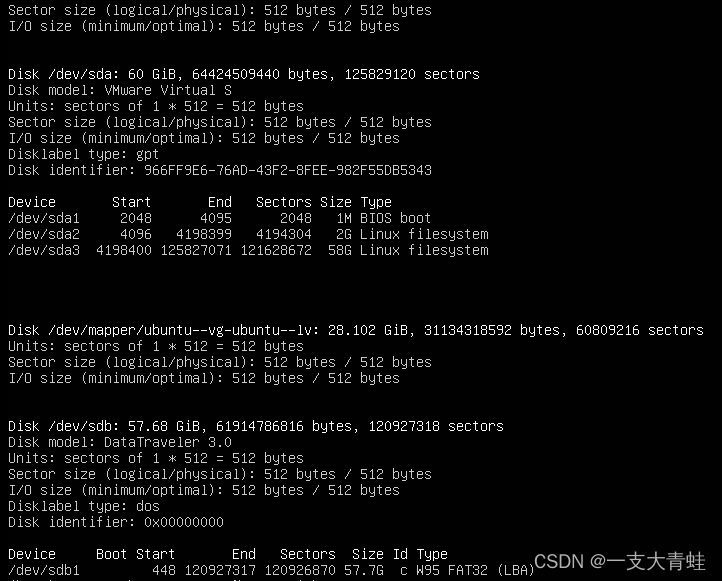

sudo fdisk -l 此命令会列出所有硬盘,需要自行根据U盘空间大小确定输出结果是否包含自己的U盘。

这里已识别出/dev/sdb1 的57.7G大小的FAT32存储格式的U盘。

(2)挂载U盘到目标位置

使用命令:

sudo mount [U盘位置] [目标位置] 例如我想将U盘挂载到

~/Hard_drive目录下:sudo mount /dev/sdb1 ~/Hard_drive

(3)将U盘中的目标资源拷贝到内网服务器中

使用命令:

sudo cp [U盘中目标资源位置] [目标位置] 例如我想将U盘中的

qwen1_5-0_5b-chat-q4_k_m.gguf文件拷贝到~/LLM_weights目录下:sudo cp ~/Hard_drive/qwen1_5-0_5b-chat-q4_k_m.gguf ~/LLM_weights/

(4)目标资源传输完成,取消挂载,拔除U盘

先使用如下命令取消挂载:

sudo umount [挂载位置] 例如我想将U盘取消挂载:

sudo umount ~/Hard_drive

最后拔出U盘。

Miniconda的安装

1. 下载Miniconda Linux安装脚本

下载地址:Miniconda 官网

2. 将脚本传输至内网服务器

3. 离线安装Miniconda

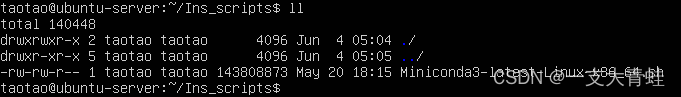

执行命令:

bash ./Miniconda3-latest-Linux-x86_64.sh ![![[Pasted image 20240604130732.png]]](/uploadfile/202501/797897b21acfd8a.png)

然后根据安装提示顺利安装Miniconda![![[Pasted image 20240604131233.png]]](/uploadfile/202501/dd29e7011635794.png)

Ollama的安装

Ollama手动安装手册:Ollama github仓库

1. 下载Ollama

下载地址:https://ollama.com/download/ollama-linux-amd64

2. 将下载的文件传输至内网服务器

![![[Pasted image 20240604132217.png]]](/uploadfile/202501/5dc153575cae628.png)

3. 将该文件保存为/usr/bin/ollama

(1)执行命令,将ollama-linux-amd64文件移动到/usr/bin/目录下:

sudo mv ollama-linux-amd64 /usr/bin/ (2)执行命令,将ollama-linux-amd64重命名为ollama

sudo mv /usr/bin/ollama-linux-amd64 /usr/bin/ollama (3)执行命令,给ollama文件添加执行权限

sudo chmod +x /usr/bin/ollama 4. 将ollama设置为服务

sudo useradd -r -s /bin/false -m -d /usr/share/ollama ollama 5. 创建/etc/systemd/system/ollama.service文件

文件内容:

[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/usr/bin/ollama serve User=ollama Group=ollama Restart=always RestartSec=3 [Install] WantedBy=default.target 6. 启动服务

依次执行以下两条命令:

sudo systemctl daemon-reload sudo systemctl enable ollama ![![[Pasted image 20240604133734.png]]](/uploadfile/202501/c675e111b6a16d1.png)

7. 验证成功安装

输入ollama观察输出结果。![![[Pasted image 20240604134140.png]]](/uploadfile/202501/e46c1842ab3cbb4.png)

Ollama内网部署大模型(以qwen为例)

ollama内网大模型部署文档:ollama离线部署大模型

1. 下载目标大模型的权重文件

注意要下载以.gguf结尾的权重文件

2. 将权重文件传输到内网服务器

![![[Pasted image 20240604142942.png]]](/uploadfile/202501/2b35598b74a93bd.png)

3. 创建Modelfile文件

文件内容如下:

FROM ./qwen1_5-0_5b-chat-q5_k_m.gguf # 需要指定.gguf文件位置 TEMPLATE """{{ if .System }}<|im_start|>system {{ .System }}<|im_end|>{{ end }}<|im_start|>user {{ .Prompt }}<|im_end|> <|im_start|>assistant """ PARAMETER stop "<|im_start|>" PARAMETER stop "<|im_end|>" 说明:不同模型的 Modelfile 内容不同,可参考 Ollama 官网

4. 在Ollama中创建模型

执行命令:

ollama create [模型名] -f [Modelfile位置] ![![[Pasted image 20240604143927.png]]](/uploadfile/202501/bf945d5c28ede40.png)

5. 确认创建成功

运行如下命令,观察输出。

ollama list ![![[Pasted image 20240604144038.png]]](/uploadfile/202501/ca7be775d821569.png)

外网环境整体迁移

参考链接:https://www.cnblogs.com/jack-nie-23/p/16900926.html

1. 打包外网机环境

(1)外网机安装conda-pack

conda install conda-pack (2)外网机打包指定环境

conda pack -n [指定要打包的虚拟环境名xxx] 执行完成后会在当前终端目录下生成xxx.tar.gz的压缩包文件。![![[Pasted image 20240604150204.png]]](/uploadfile/202501/69d5bba799a1f06.png)

2. 将torch.tar.gz压缩包文件传输到内网服务器上

![![[Pasted image 20240604150658.png]]](/uploadfile/202501/b883fedf79134a1.png)

3. 内网机上新建文件夹

在内网机的miniconda安装目录下的envs目录中新建和打包环境名一致的文件夹。使用命令如下:

mkdir ~/miniconda3/envs/torch 4. 将torch.tar.gz压缩包解压至miniconda的envs/torch目录下

tar -xzf env_name.tar.gz -C ~/miniconda3/envs/env_name/ ![![[Pasted image 20240604151521.png]]](/uploadfile/202501/c5c022a3e22a.png)

5. 测试环境是否移植成功

使用命令切换环境,观察输出结果:

conda activate torch ![![[Pasted image 20240604151637.png]]](/uploadfile/202501/bd0dc01e512025c.png)

内网机安装某个pip包(以rich包为例)

参考链接imshuai

方法一:

1. 当前环境中无rich包

![![[Pasted image 20240604151940.png]]](/uploadfile/202501/67fd4908b9a1754.png)

2. 进入pypi 中搜索rich,进入目标页面

![![[Pasted image 20240604152056.png]]](/uploadfile/202501/a5571b188efc655.png)

![![[Pasted image 20240604152143.png]]](/uploadfile/202501/113e45ddcb4180f.png)

3. 点击Download files,选择.whl库文件进行下载

![![[Pasted image 20240604152359.png]]](/uploadfile/202501/1a9ce94ac2ec841.png)

4. 将下载的文件传输到内网服务器上

![![[Pasted image 20240604152735.png]]](/uploadfile/202501/0fd6bc8a4343d77.png)

5. 使用命令安装

pip install rich-13.7.1-py3-none-any.shl 说明:

当没有依赖问题时使用此方法可直接安装相应库,如果遇到依赖问题,可尝试下面的方法二

方法二:

1. 在外网机上使用pip下载rich

使用命令:

pip download rich 命令执行完成后,会在当前目录下生成所有依赖库。![![[Pasted image 20240604154707.png]]](/uploadfile/202501/34c4c8261006b89.png)

2. 将其全部传输到内网服务器中

![![[Pasted image 20240604155240.png]]](/uploadfile/202501/8163480de19937e.png)

3. 使用命令安装

命令如下:

pip install --no-index --find-links=[所有依赖文件夹位置] rich-13.7.1-py3-none-any.whl ![![[Pasted image 20240604155601.png]]](/uploadfile/202501/a7eb4a562a508b5.png)