AI算法19-偏最小二乘法回归算法Partial Least Squares Regression | PLS

偏最小二乘法回归算法简介

算法概述

偏最小二乘法模型可分为偏最小二乘回归模型和偏最小二乘路径模型。其中偏最小二乘回归模型是一种新型的多元统计方法,它集中了主成分分析、典型相关分析和线性回归的特点,特别在解决回归中的共线性问题具有无可比拟的优势。偏最小二乘回归模型虽然与主成分分析有关系,但它不是寻找响应和独立变量之间最小方差的超平面,而是通过投影预测变量和观测变量到一个新空间来寻找一个线性回归模型。特别当两组变量的个数很多,且存在多重相关性,而观测数据的数量较少时,用偏最小二乘回归建立的模型具有传统的经典回归分析等方法所没有的优点。

偏最小二乘路径模型是偏最小二乘法的应用,可以应用于一些难以直接观测的现象进行分析,也可以考察分析现象之间的关联关系等。偏最小二乘路径模型降低了结构方程需要大量的样本数据,且观测变量服从多元正态分布的要求。模型的工作目标与结构方程模型基本一致,但与结构方程基本协方差矩阵建模的思路不同,偏最小二乘路径模型采用的是一系列一元或多元线性回归的迭代求解。在实际应用中无需对观测变量做特定的概率分布假设,也不存在模型不可识别问题,并且由于采用偏最小二乘法,对样本容量的要求也非常宽松。由此可见,偏最小二乘路径模型是一种更加实用和有效的线性建模方法。

算法发展历史

1975年,在求解实际应用中发现很多的问题不能用结构方程求解,所以伍德等人提出更为简单的分析技术,即偏最小二乘路径模型。与结构方程相比,该方法使用条件更为广泛,效果更好。

1983年,瑞典统计学家Herman Wold和阿巴诺最先提出了最小二乘法,并将其应用于社会科学中;然后由赫曼的儿子Svante Wold发展这个理论。

特别是近十年来,偏最小二乘在理论、方法和应用方面都得到了迅速的发展。密西根大学的佛奈尔教授称偏最小二乘回归为第二代回归方法。

偏最小二乘法回归算法原理

现实问题中的自变量之间往往会存在大量的自相关情况,所以对这类问题使用普通的最小二乘法不能够求解;这是因为变量多重相关性会严重危害参数估计,扩大模型误差,并且破坏模型的稳定性。偏最小二乘法开辟了一种有效的技术途径,它利用对系统中的数据信息进行分解和筛选的方式,提取对因变量的解释性最强的综合变量,辨识系统中的信息与噪声,从而更好地克服变量多重相关性在系统建模中的不良作用。

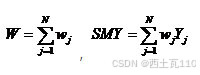

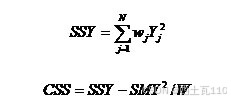

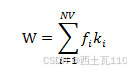

第一步:对原始数据X和Y进行标准化得到X0和Y0,其中X为m维的数据,Y是p维的数据;从Y0中选择方差最大的一列作为u1,方便后面计算;因为选取方差最大就表示该列是最能反映原始数据信息的一列,即根据主成分分析的思想,我们称这列向量为第一主成分,并使X与Y之间的相关性达最大。

标准化后的矩阵:

第二步:迭代求解X与Y的变换权重(w1,c1)和综合因子(t1,u1),直到收敛;

假设X与Y提取的主成分为t1和u1,t1是自变量集![]() 的线性组合:

的线性组合:![]() ,u1是因变量集

,u1是因变量集![]() 的线性组合:

的线性组合:![]() ;为了回归分析的需求,需要满足两个要求:t1和u1各自尽可能多的提取所在变量组的变异信息;t1和u1的相关性达到最大。

;为了回归分析的需求,需要满足两个要求:t1和u1各自尽可能多的提取所在变量组的变异信息;t1和u1的相关性达到最大。

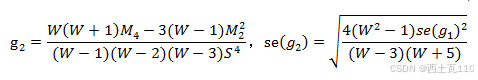

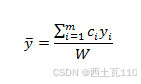

计算公式:

利用第一步选择的Y中的列,求解X的变换权重因子

利用X的信息t1,求解Y的变换权重c1,并且更新因子u1的值

判断是否已找到合理的解,否则继续寻找。

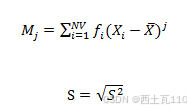

其中t1和u1的估计方程为:

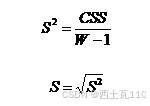

第三步:求X与Y的残差矩阵;

计算公式:

1.求X的载荷P1,载荷是反映X0和因子T1的直接关系:

2.求X0的残差X1,残差表示了u1不能反映X0信息的部分:

![]()

3.求Y的载荷Q1:

![]()

4.建立X因子t1与Y因子u1之间的回归模型,并用t1预测u1的信息;

5.求Y0的残差Y1,这个值表达了X与因子t1所不能预测的Y0中的信息:

第四步:利用X1与Y1,重复上述步骤,求解下一个主成分的偏最小二乘的参数。

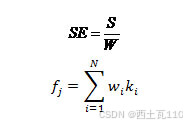

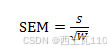

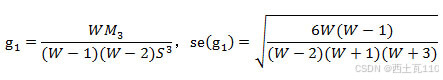

最后得到偏最小二乘回归模型的回归方程,还应该对回归系数进行检验;一般情况下,可以通过交叉有效性检验来确定。交叉有效性检验通过求解预测误差平方和与误差平方和的比值,这个比值越小越好,一般设置的限定值为0.05,所以当该比值越小,增加新的主成分有利于提高模型的精度;反之认为增加新的成分,对减少方程的预测误差无明显的改善作用。

定义交叉有效性:

这样,在建模时每一步计算结束前,均进行交叉有效性检验,如果在第h步有

时模型已达到精度要求,可停止提取成分,若

表示第h步提取的

![]()

成分的边际贡献显著,应继续第h+1步计算。

偏最小二乘法回归算法代码实现

import numpy as np def pls_regression(X, Y, L): """ 偏最小二乘回归算法。 参数: X : numpy.ndarray 特征矩阵,每一行是一个样本,每一列是一个特征。 Y : numpy.ndarray 目标矩阵,每一行是一个样本,每一列是一个目标变量。 L : int 要提取的潜在变量数量。 返回: T : numpy.ndarray X的得分矩阵。 U : numpy.ndarray Y的得分矩阵。 P : numpy.ndarray X的权重矩阵。 Q : numpy.ndarray Y的权重矩阵。 """ n, p = X.shape m, _ = Y.shape W = np.zeros((p, L)) Q = np.zeros((p, L)) P = np.zeros((m, L)) U = np.zeros((m, L)) T = np.zeros((n, L)) for i in range(L): # 计算权重向量 Xtx = X.T @ X Xty = X.T @ Y W[:, i] = Xty / np.sqrt(Xtx @ W[:, i]) # 计算得分向量 T[:, i] = X @ W[:, i] # 计算Y的权重和得分 Yty = Y.T @ Y U[:, i] = Yty @ W[:, i] / np.linalg.norm(W[:, i]) Q[:, i] = Y.T @ U[:, i] # 计算X和Y的权重 P[:, i] = Xty @ U[:, i].T / np.linalg.norm(U[:, i]) # 去相关 X = X - T @ W[:, i].T Y = Y - U[:, i] @ Q[:, i].T return T, U, P, Q # 示例数据 X = np.random.rand(100, 10) # 100个样本,10个特征 Y = np.random.rand(100, 1) # 100个样本,1个目标变量 # 调用PLS回归函数 L = 3 # 假设我们想要3个潜在变量 T, U, P, Q = pls_regression(X, Y, L) # 使用得到的权重和得分进行预测 Y_pred = T @ P.T偏最小二乘法回归算法优缺点

算法优点:

- 处理多重共线性:PLS能够在自变量存在严重多重相关性的条件下进行回归建模 。

- 样本量少于变量数:允许在样本点个数少于变量个数的条件下进行回归建模 。

- 包含所有自变量:在最终模型中将包含原有的所有自变量 。

- 辨识系统信息与噪声:模型更易于辨识系统信息与噪声,包括一些非随机性的噪声 。

- 易于解释的系数:每一个自变量的回归系数将更容易解释 。

- 预测性能:在提取主成分的过程中,考虑了自变量与因变量之间的关联,使得提取的主成分能同时优化因变量预测性能,因此通常在预测任务上能取得更好的结果 。

- 适用于高通量数据:适用于诸如基因组学、转录组学等高通量数据分析,在这些领域中自变量数目可能大于样本数 。

算法缺点:

- 线性假设限制:PLS回归本身是线性模型,尽管可以处理一定程度的非线性关系,但在非线性关系强烈的场景下可能不如非线性模型有效 。

- 模型选择问题:在PLS中,需要选择合适的潜在变量数量,这可能需要依赖经验和交叉验证来确定 。

- 计算复杂性:相比于简单的线性回归,PLS的计算过程更为复杂,可能需要更多的计算资源。

- 过度依赖主成分:如果主成分不能很好地代表数据的变异性,PLS模型可能无法提供准确的预测 。

- 对异常值敏感:PLS方法可能对数据中的异常值比较敏感,这可能影响模型的稳定性和预测能力 。

偏最小二乘法回归算法应用

偏最小二乘法回归算法(PLS)在多个领域有着广泛的应用,以下是一些常见的应用场景:

- 化学计量学:PLS回归特别适用于处理化学光谱数据分析,例如近红外光谱(NIR)、紫外可见光谱(UV-Vis)、拉曼光谱等。这些光谱数据通常包含大量的变量(如不同波长处的吸光度),并且各变量间可能存在高度相关性。通过PLS回归,研究者可以从复杂的光谱数据中构建预测模型,将光谱信息与样品的化学成分、物理性质或工艺参数等联系起来,实现无损、快速的定量或定性分析 。

- 金融行业:在风险管理中,PLS回归能够处理多种可能具有共线性的财务指标,帮助金融机构预测公司的信用风险、违约概率或其他金融表现指标。通过结合众多的财务报表数据,如资产负债率、流动比率、盈利能力指标等,PLS回归模型可以发现这些变量与潜在违约行为间的非线性关系,从而优化风险评估体系 。

- 生物医学研究:在基因表达数据分析中,PLS回归被用来探索基因表达谱(如RNA测序或微阵列数据)与临床表型(如疾病状态、药物反应、生存率等)之间的关联。由于基因数据通常是高维度且具有噪声,而样本数量相对较少,因此PLS回归能够减少数据维度,并在小样本情况下找到基因表达模式与疾病发展或治疗响应的重要关联 。

- 环境科学:PLS回归在环境科学中被用于分析环境污染物的监测数据,预测环境质量变化趋势。通过处理高维且可能存在多重共线性的环境监测数据,PLS回归可以帮助科学家更准确地预测和评估环境变化 。

- 社会科学:在社会科学研究中,PLS回归常用于分析复杂的社会经济数据,如消费者行为、社会态度等。由于这些数据通常包含多个相关变量,PLS回归能够提取关键因素,建立预测模型 。

- 市场营销和战略管理:PLS回归在市场营销和战略管理中被用来分析消费者满意度、品牌忠诚度等多维数据,帮助企业更好地理解市场动态和消费者需求 。

- 小样本数据分析:PLS回归特别适用于小样本数据的情况。在样本数量较少但变量较多的情况下,PLS回归能够通过提取主成分进行有效的回归分析,避免了传统回归方法在这种情况下可能出现的问题 。

- 高维数据处理:在自变量和因变量维数都很高的情况下,PLS回归通过降维技术,能够提炼出最重要的信息并构建预测模型,提高了模型的解释性和预测性能 。

- 处理多重共线性:PLS回归能够有效克服因变量和自变量之间存在的多重共线性问题,即使自变量之间高度相关,也能通过提取主成分进行有效的回归分析

上一篇:发现玩家!(德州版wpk)透视辅助!(透视)外挂辅助器测试(2025已更新)(哔哩哔哩)

下一篇:【Diffusion学习】【生成式AI】Stable Diffusion、DALL-E、Imagen 背後共同的套路