弹性网络回归(Elastic Net Regression)

创始人

2025-01-08 04:36:42

0次

弹性网络回归(Elastic Net Regression)的详细理论知识推导

理论背景

弹性网络回归结合了岭回归(Ridge Regression)和Lasso回归(Lasso Regression)的优点,通过引入两个正则化参数来实现特征选择和模型稳定性。它解决了Lasso在处理高相关特征时的缺陷,并且在处理高维数据时表现优异。

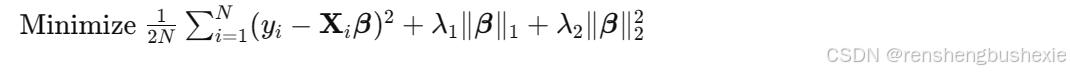

数学公式

Elastic Net回归的损失函数如下:

其中:

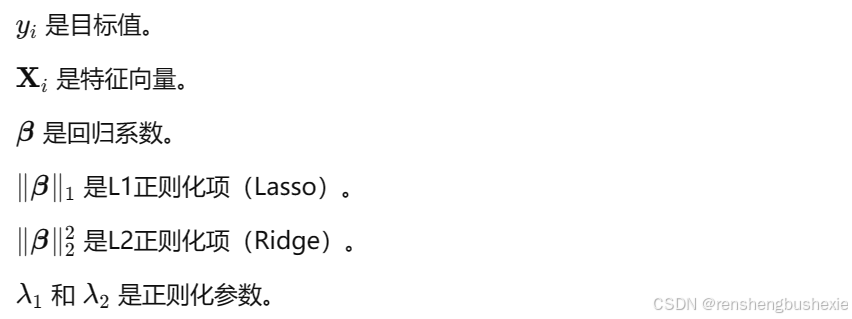

推导

目标函数:Elastic Net的目标函数是均方误差(MSE)和两个正则化项的加权和。

梯度下降:通过梯度下降法求解目标函数的最小值,更新回归系数。

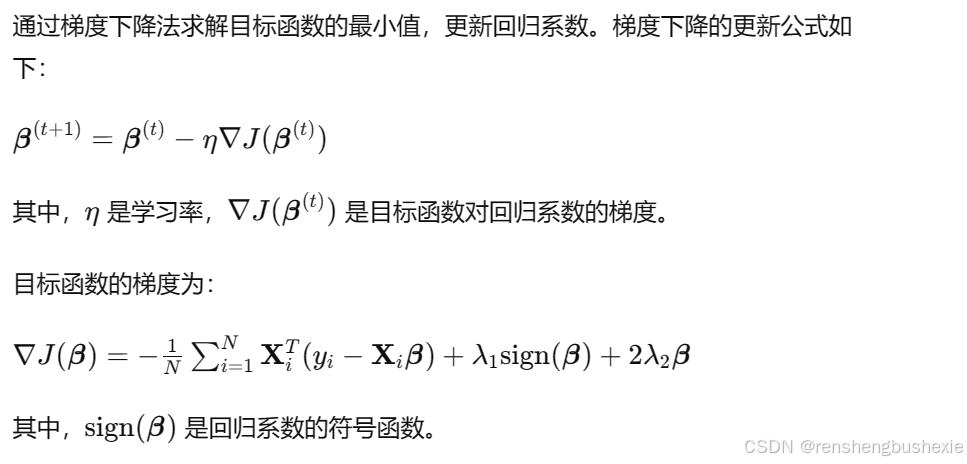

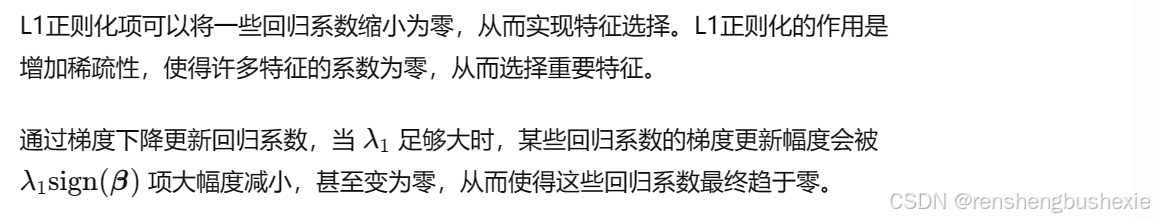

特征选择:L1正则化项可以将一些回归系数缩小为零,从而实现特征选择。

模型稳定性:L2正则化项增加了模型的稳定性,减少过拟合。

实施步骤

数据预处理:标准化或归一化数据。

拆分数据集:将数据集拆分为训练集和测试集。

模型训练:使用Elastic Net回归模型进行训练。

模型评估:使用测试集评估模型性能。

参数解读

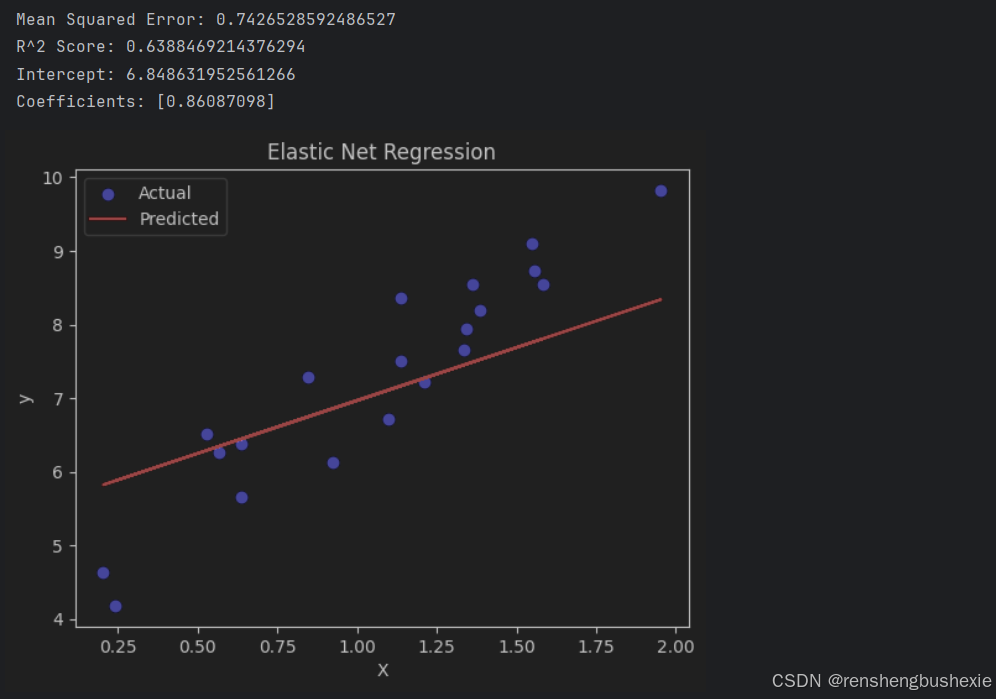

未优化模型实例

import numpy as np import matplotlib.pyplot as plt from sklearn.linear_model import ElasticNet from sklearn.metrics import mean_squared_error, r2_score from sklearn.model_selection import train_test_split from sklearn.preprocessing import StandardScaler # 生成示例数据 np.random.seed(0) X = 2 * np.random.rand(100, 1) y = 4 + 3 * X + np.random.randn(100, 1) * 0.5 # 数据分割为训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # 数据标准化 scaler = StandardScaler() X_train_scaled = scaler.fit_transform(X_train) X_test_scaled = scaler.transform(X_test) # 转换 y_train 和 y_test 为一维数组 y_train = y_train.ravel() y_test = y_test.ravel() # 创建Elastic Net回归模型 elastic_net = ElasticNet(alpha=1.0, l1_ratio=0.5) elastic_net.fit(X_train_scaled, y_train) # 进行预测 y_pred = elastic_net.predict(X_test_scaled) # 模型评估 mse = mean_squared_error(y_test, y_pred) r2 = r2_score(y_test, y_pred) print(f"Mean Squared Error: {mse}") print(f"R^2 Score: {r2}") print(f"Intercept: {elastic_net.intercept_}") print(f"Coefficients: {elastic_net.coef_}") # 可视化结果 plt.scatter(X_test, y_test, color='blue', label='Actual') plt.plot(X_test, y_pred, color='red', label='Predicted') plt.xlabel("X") plt.ylabel("y") plt.title("Elastic Net Regression") plt.legend() plt.show() 可视化展示

结果解释

Mean Squared Error (MSE): 表示预测值与实际值之间的平均平方误差。值越小,模型性能越好。

R^2 Score: 决定系数,度量模型的拟合优度。值越接近1,模型解释力越强。

Intercept: 截距,表示回归方程在y轴上的截距。

Coefficients: 回归系数,表示自变量对因变量的影响。

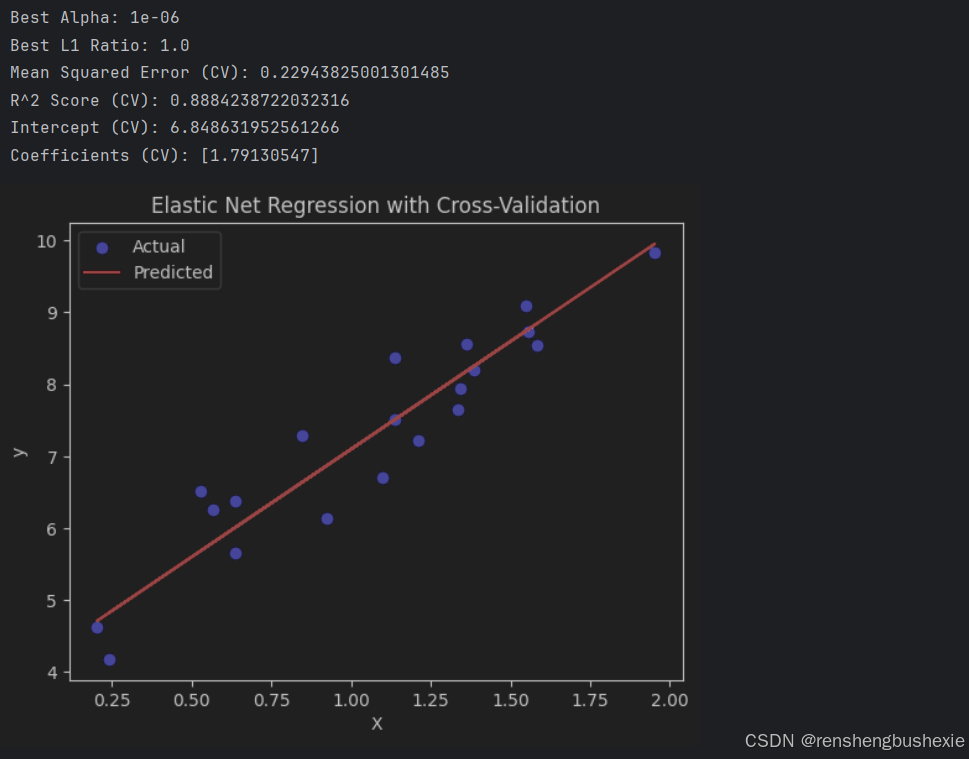

优化后的模型实例

from sklearn.linear_model import ElasticNetCV # 创建带交叉验证的Elastic Net回归模型 elastic_net_cv = ElasticNetCV(alphas=np.logspace(-6, 6, 13), l1_ratio=np.linspace(0.1, 1.0, 10), cv=5) elastic_net_cv.fit(X_train_scaled, y_train) # 进行预测 y_pred_cv = elastic_net_cv.predict(X_test_scaled) # 模型评估 mse_cv = mean_squared_error(y_test, y_pred_cv) r2_cv = r2_score(y_test, y_pred_cv) print(f"Best Alpha: {elastic_net_cv.alpha_}") print(f"Best L1 Ratio: {elastic_net_cv.l1_ratio_}") print(f"Mean Squared Error (CV): {mse_cv}") print(f"R^2 Score (CV): {r2_cv}") print(f"Intercept (CV): {elastic_net_cv.intercept_}") print(f"Coefficients (CV): {elastic_net_cv.coef_}") # 可视化结果 plt.scatter(X_test, y_test, color='blue', label='Actual') plt.plot(X_test, y_pred_cv, color='red', label='Predicted') plt.xlabel("X") plt.ylabel("y") plt.title("Elastic Net Regression with Cross-Validation") plt.legend() plt.show() 可视化展示

结果解释

- Best Alpha: 通过交叉验证选择的最佳正则化参数。

- Best L1 Ratio: 通过交叉验证选择的最佳L1正则化比例。

- Mean Squared Error (CV): 交叉验证后的均方误差。

- R^2 Score (CV): 交叉验证后的决定系数。

- Intercept (CV): 交叉验证后的截距。

- Coefficients (CV): 交叉验证后的回归系数。

通过比较两个实例,可以看出优化后的模型通过交叉验证选择了最佳的正则化参数,从而提高了模型的预测性能和泛化能力。

相关内容

热门资讯

第3分钟辅助挂!新悠悠辅助,四...

四川家园游戏辅助软件是一款可以让一直输的玩家,快速成为一个“必胜”的ai辅助神器,有需要的用户可以加...

透视免费!蜜瓜大厅辅助免费下载...

【亲,小程序广东雀神智能插件安装下载 这款游戏可以开挂的,确实是有挂的,很多玩家在这款小程序广东雀神...

两方式!微信小程序游戏破解微乐...

>>您好:微信小程序游戏破解微乐游戏确实是有挂的,很多玩家在这款微信小程序游戏破解微乐游戏游戏中打牌...

大家学习交流!同乡游辅助工具制...

您好:同乡游辅助工具制作这款游戏可以开挂的,确实是有挂的,很多玩家在这款游戏中打牌都会发现很多用户的...

1分钟辅助挂!闲逸透视app使...

您好:闲逸透视app使用教程这款游戏可以开挂的,确实是有挂的,很多玩家在这款游戏中打牌都会发现很多用...

透视规律!随意玩房卡辅助,微乐...

您好:这款微乐自建房辅助工具2025在哪游戏是可以开挂的,确实是有挂的,很多玩家在这款微乐自建房辅助...

8学习!微乐自建房辅助神器怎么...

【亲,广东雀神智能插件安装包免费 这款游戏可以开挂的,确实是有挂的,很多玩家在这款广东雀神智能插件安...

2分钟细说!山西扣点免费辅助,...

山西扣点免费辅助开挂教程视频分享装挂详细步骤在当今的网络游戏中,山西扣点免费辅助作为一种经典的娱乐方...

六分钟辅助挂!中至小程序破解,...

六分钟辅助挂!中至小程序破解,蜀山四川破解版安卓版(体悟透视开挂辅助器)您好:蜀山四川破解版安卓版这...

透视插件!wpk俱乐部是真的吗...

透视插件!wpk俱乐部是真的吗,广东插件智能插件安装包免费,新2026版(新版有挂) 了解更多开挂安...