分布式启动入门

创始人

2025-01-08 04:34:25

0次

一、定义

- 定义

- 案例

二、实现

定义

- rank:进程号,在多进程上下文中,我们通常假定rank 0是第一个进程或者主进程,其它进程分别具有1,2,3不同rank号,这样总共具有4个进程

- node:物理节点,可以是一个容器也可以是一台机器,节点内部可以有多个GPU;nnodes指物理节点数量, nproc_per_node指每个物理节点上面进程的数量

- local_rank:指在一个node上进程的相对序号,local_rank在node之间相互独立

- WORLD_SIZE:全局进程总个数,即在一个分布式任务中rank的数量

- Group:进程组,一个分布式任务对应了一个进程组。只有用户需要创立多个进程组时才会用到group来管理,默认情况下只有一个group

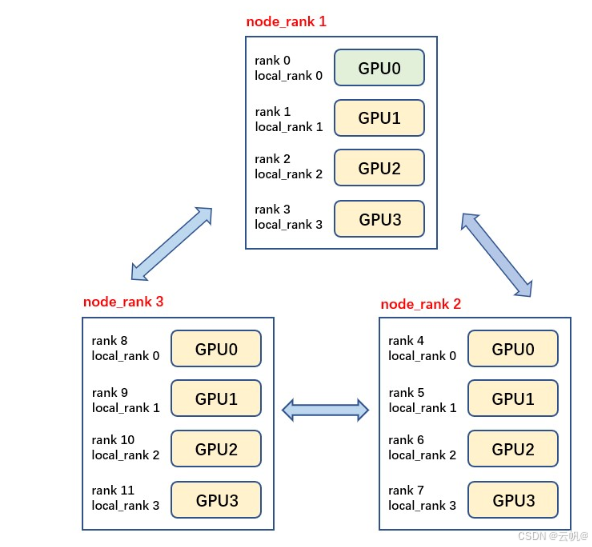

共有3个节点(机器),每个节点上有4个GPU,每台机器上起4个进程,每个进程占一块GPU,那么图中一共有12个rank,nproc_per_node=4,nnodes=3,每个节点都一个对应的node_rank。

案例1

- 使用torch.multiprocessing(python的multiprocessing的封装类) 来自动生成多个进程.

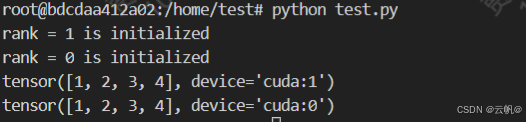

mp.spawn(fn, args=(), nprocs=1, join=True, daemon=False) #自动生成多个进程 fn: 进程的入口函数,该函数的第一个参数会被默认自动加入当前进*程的rank, 即实际调用: fn(rank, *args) nprocs: 进程数量,即:world_size args: 函数fn的其他常规参数以tuple的形式传递 import torch import torch.distributed as dist import torch.multiprocessing as mp def fn(rank, ws, nums): dist.init_process_group('nccl', init_method='tcp://127.0.0.1:28765', rank=rank, world_size=ws) rank = dist.get_rank() print(f"rank = {rank} is initialized") torch.cuda.set_device(rank) tensor = torch.tensor(nums).cuda() print(tensor) if __name__ == "__main__": ws = 2 mp.spawn(fn, nprocs=ws, args=(ws, [1, 2, 3, 4])) # python test.py

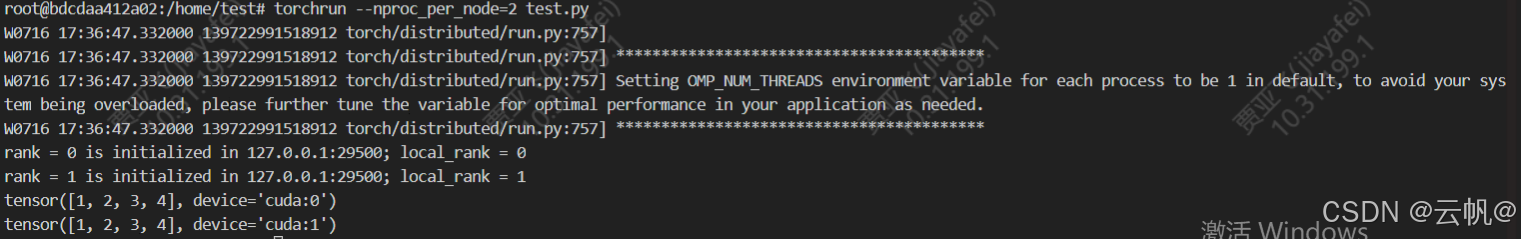

2. 使用torchrun 启动

import torch import torch.distributed as dist import torch.multiprocessing as mp import os dist.init_process_group('nccl', init_method='env://') rank = dist.get_rank() local_rank = os.environ['LOCAL_RANK'] master_addr = os.environ['MASTER_ADDR'] master_port = os.environ['MASTER_PORT'] print(f"rank = {rank} is initialized in {master_addr}:{master_port}; local_rank = {local_rank}") torch.cuda.set_device(rank) tensor = torch.tensor([1, 2, 3, 4]).cuda() print(tensor) #torchrun --nproc_per_node=2 test.py --nnodes: 使用的机器数量,单机的话,就默认是1了 --nproc_per_node: 单机的进程数,即单机的worldsize --master_addr/port: 使用的主进程rank0的地址和端口 --node_rank: 当前的进程rank

参考:

相关内容

热门资讯

分享开挂!雷霆辅助器,wepo...

较多好评“微乐万能挂官网”开挂(透视)辅助教程 了解更多开挂安装加(136704302)微信号是一款...

了解辅助!欢乐达人猜猜乐友挂吗...

了解辅助!欢乐达人猜猜乐友挂吗,wpk辅助插件,微扑克教程(有挂秘笈)-哔哩哔哩《详细加薇13670...

正品辅助!乐达app辅助,uu...

正品辅助!乐达app辅助,uupoker有透视吗,必胜教程(果真有挂)-哔哩哔哩>>您好:软件加13...

分享辅助!娱网皮球茶馆脚本,扑...

分享辅助!娱网皮球茶馆脚本,扑克之星辅助,透视教程(真的有挂)-哔哩哔哩《详细加薇136704302...

科技开挂!九九山城插件程序,w...

科技开挂!九九山城插件程序,wepoker破解器激活码,详细教程!(有人有挂)-哔哩哔哩 了解更多开...

正品开挂!中至窝龙辅助,wpk...

正品开挂!中至窝龙辅助,wpk辅助器,普及教程(有挂秘籍)-哔哩哔哩1、下载安装好中至窝龙辅助,进入...

必看开挂!樱花之盛微信辅助,w...

必看开挂!樱花之盛微信辅助,wepoker免费透视,黑科技教程(有挂解密)-哔哩哔哩 【无需打开直接...

必看开挂!新上游反杀辅助,hh...

必看开挂!新上游反杀辅助,hhpkoer辅助器视频,新2026版(有挂分析)-哔哩哔哩;无需打开直接...

正版辅助!微信超级三加一辅助软...

正版辅助!微信超级三加一辅助软件,佛手在线大菠萝智能辅助器,详细教程(确实有挂)-哔哩哔哩 【无需打...

科技辅助!渝都亲友全辅助,ha...

科技辅助!渝都亲友全辅助,hardrock辅助,分享教程(揭秘有挂)-哔哩哔哩【无需打开直接搜索加薇...