最新开源AI搜索引擎!Perplexica:Perplexity AI平替、100%本地、Ollama接入各类大模型、学术搜索

原文链接:(更好排版、视频播放、社群交流、最新AI开源项目、AI工具分享都在这个公众号!)

最新开源AI搜索引擎!Perplexica:Perplexity AI平替、100%本地、Ollama接入各类大模型、学术搜索

🌟🚀 Perplexica - 人工智能驱动的搜索引擎🔎,它是 Perplexity AI (国外火热的闭源AI搜索引擎)的

开源的替代品,支持将浏览器基础搜索引擎替换为Perplexica,一个新的、 100%本地私密搜索的LLM项目。

仓库地址: https://github.com/ItzCrazyKns/Perplexica

在本文中,我将介绍一个名为 Perplexica 的新工具, Perplexica 非常容易安装,还可以与任何开源大型语言模型(LLM)一起使用,如

Mixtral 8x22b、Mixtral 8x7b、GPT-4、Grok-1.5 和 Gemini Code Assist、Github Copilot

等。

这里推荐油管博主AICodeKing教程:

关键信息

🚀 Perplexica 是对 Perplexity 的一种革命性替代方案,提供了一个免费和开源的解决方案,用于互联网搜索。

🔒 使用 Perplexica ,您可以享受私密和安全的搜索体验,不必担心您的数据被出售给第三方公司。

🤖 Perplexica 通过 Ollama 使用本地 LLMs,让您可以根据具体的使用场景选择最佳选项。

📊 平台提供六种焦点模式,包括全模式、写作助手模式、学术搜索模式、YouTube 搜索模式、Wolfram Alpha 搜索模式和 Reddit 搜索模式。

🎯 Perplexica 是完全可定制的,允许您根据自己的需求和偏好进行调整。

💻 您可以使用 Docker 或不使用 Docker 来安装 Perplexica ,便于您开始使用。

📈 Perplexica 还是一个相对较新的项目,但其活跃的 GitHub 社区正在快速推进更改以解决任何出现的问题。

📁 Perplexica 不仅限于搜索网络,还可以让您搜索本地文件,并构建自己的 AI 驱动应用程序。

架构

Perplexica 的架构包括以下关键组件:

1. 用户界面 :一个基于 Web 的界面,允许用户与 Perplexica 进行交互,搜索图像、视频等。

2. Agent/Chains :这些组件预测 Perplexica 的下一步操作,理解用户查询,并决定是否需要进行网络搜索。

3. SearXNG :Perplexica 使用的元数据搜索引擎,用于在网络上搜索来源。

4. LLMs(大型语言模型) :由代理和链使用,用于理解内容、撰写响应并引用来源。例如 Claude、GPT 等。

5. 嵌入模型 :为了提高搜索结果的准确性,嵌入模型使用诸如余弦相似度和点积距离等相似性搜索算法对结果进行重新排序。

🚀 Perplexica - 一个由人工智能驱动的搜索引擎 🔎

概述

Perplexica 是一个开源的人工智能搜索工具或人工智能搜索引擎,深入互联网以找到答案。受 Perplexity AI

的启发,它是一个开源选项,不仅搜索网络,还能理解您的问题。它使用高级机器学习算法,如相似度搜索和嵌入,以精细结果,并提供带有引用来源的清晰答案。

使用 SearxNG 保持当前并完全开源,Perplexica 确保您始终获取最新信息,而不会损害您的隐私。

想了解更多关于它的架构和工作原理?您可以在 这里 阅读。

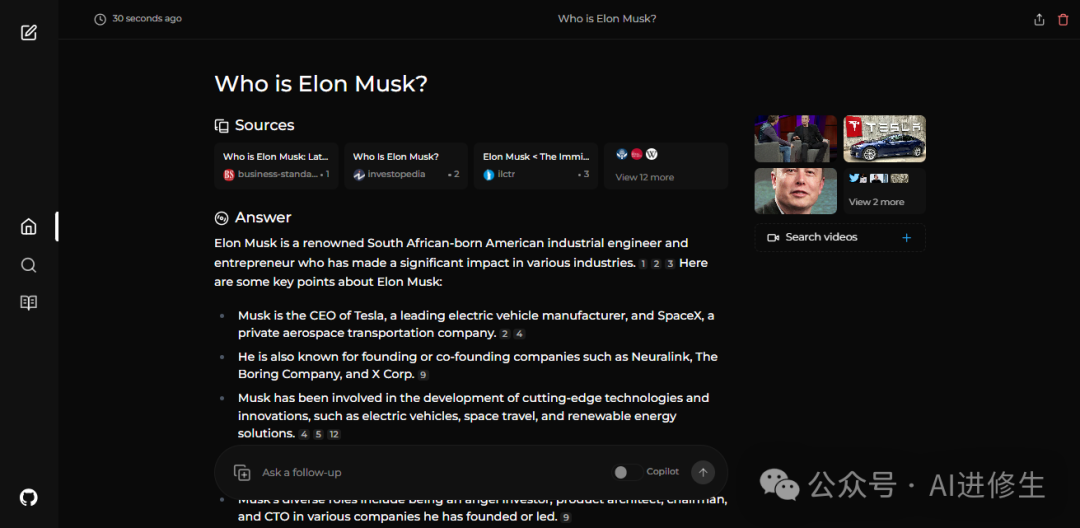

预览

特性

• 本地LLMs :您可以使用Ollama使用本地LLMs,例如Llama3和Mixtral。

• 两种主要模式:

• Copilot模式: (开发中)通过生成不同的查询来增强搜索,以找到更相关的互联网来源。与SearxNG仅使用上下文不同的是,它访问前几名匹配项,并尝试直接从页面中找到与用户查询相关的来源。

• 普通模式: 处理您的查询并执行网络搜索。

• 焦点模式: 特殊模式以更好地回答特定类型的问题。Perplexica 目前具有6种焦点模式:

• 全部模式: 搜索整个网络以找到最佳结果。

• 写作助手模式: 适用于不需要搜索网络的写作任务。

• 学术搜索模式: 查找文章和论文,适用于学术研究。

• YouTube搜索模式: 根据搜索查询查找YouTube视频。

• Wolfram Alpha搜索模式: 使用Wolfram Alpha回答需要计算或数据分析的查询。

• Reddit搜索模式: 搜索Reddit,查找与查询相关的讨论和观点。

• 当前信息: 一些搜索工具可能会给您过时的信息,因为它们使用爬网机器人的数据并将它们转换为嵌入并存储在索引中。与它们不同,Perplexica 使用 SearxNG 获取结果并重新排名,从中获取最相关的源,确保您始终获取最新信息,而无需每日数据更新的开销。

它还具有许多其他功能,如图像和视频搜索。计划中的一些功能在 即将推出的功能 中提到。

安装

安装 Perplexica 有两种主要方法 - 使用 Docker,不使用 Docker。强烈推荐使用 Docker。

使用Docker入门(推荐)

1. 确保 Docker 已安装并在您的系统上运行。

2. 克隆 Perplexica 存储库:

git clone https://github.com/ItzCrazyKns/Perplexica.git

3. 克隆后,转到包含项目文件的目录。

4. 将

sample.config.toml文件重命名为config.toml。对于 Docker 设置,您只需填写以下字段:

* • ` OPENAI ` :您的 OpenAI API 密钥。 **如果您希望使用 OpenAI 的模型,则只需填写此项** 。 * • ` OLLAMA ` :您的 Ollama API URL。您应该输入为 ` http://host.docker.internal:PORT_NUMBER ` 。如果您在端口11434上安装了 Ollama,请使用 ` http://host.docker.internal:11434 ` 。对于其他端口,请相应调整。 **如果您希望使用 Ollama 的模型而不是 OpenAI 的模型,则需要填写此项** 。 * • ` GROQ ` :您的 Groq API 密钥。 **如果您希望使用 Groq 的托管模型,则只需填写此项** **注意** :您可以在从设置对话框启动 Perplexica 后更改这些设置。 * • ` SIMILARITY_MEASURE ` :要使用的相似度测量(默认已填充;如果对此不确定,可以将其保留为默认值)。 5. 确保您位于包含

docker-compose.yaml文件的目录中,并执行:docker compose up -d

6. 等待几分钟以完成设置。您可以在 Web 浏览器中访问 http://localhost:3000 来访问 Perplexica。

注意 :构建容器后,您可以直接从 Docker 启动 Perplexica,而无需打开终端。

非Docker安装

- 1. 在根目录中克

隆存储库,并将 sample.config.toml 文件重命名为 config.toml 。确保您在此文件中填写所有必填字段。2.

在 ui 文件夹中将 .env.example 文件重命名为 .env ,并填写所有必要的字段。3.

在填充配置和环境文件后,在 ui 文件夹和根目录中分别运行 npm i 。4. 在 ui

文件夹和根目录中安装依赖项,然后分别执行 npm run build 。5. 最后,在 ui 文件夹和根目录中运行 npm run start 启动前端和后端。

注意 :使用 Docker 是推荐的,因为它简化了设置过程,特别是用于管理环境变量和依赖项。

Ollama连接错误

如果您遇到Ollama连接错误,通常与后端无法连接到Ollama的API有关。您可以如何解决?您可以通过将 Ollama 的 API URL

更新为以下内容来解决:

在 Windows 上: http://host.docker.internal:11434

在 Mac 上: http://host.docker.internal:11434

在 Linux 上: http://private_ip_of_computer_hosting_ollama:11434

您需要相应地编辑端口。

一键部署

部署到RepoCloud

https://d16t0pc4846x52.cloudfront.net/deploylobe.svg

即将推出的功能

• 完善 Copilot 模式

• 添加设置页面

• 添加对本地LLMs的支持

• 添加发现和历史保存功能

• 引入各种焦点模式

知音难求,自我修炼亦艰

抓住前沿技术的机遇,与我们一起成为创新的超级个体

(把握AIGC时代的个人力量)

**

**

— 完 —

** 点这里👇关注我,记得标星哦~ **

**

**

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见 ~

预览时标签不可点

微信扫一扫

关注该公众号

轻触阅读原文

AI进修生

收藏