ubuntu系统(或者linux服务器)本地部属LLAMA3.1模型,适合新手小白

主要是手动安装,它在github给的一键安装脚本对于你在服务器上不管理员很难受,它默认安装在/usr/bin/ollama路径下,对于非管理员用户不是很友好,如果你修改它的install.sh文件另说,这些不是一个小白可以简单弄明白的。

1、下载他的二进制服务器端(不是模型本身,你可以简单理解为承载模型的服务器)

curl -L https://ollama.com/download/ollama-linux-amd64 -o /home/XXX/XX/ollama

-o 后面是你想存放的路径,比如我的是 /home/zhiqing/software/ollama

如果你是个人电脑或者拥有管理员权限可以写成(后续可以省去很多麻烦)

sudo curl -L https://ollama.com/download/ollama-linux-amd64 -o /home/XXX/XX/ollama

2、赋予权限

chmod +x /home/XXX/XX/ollama

此处路径同第一个你的路径,如果你是个人电脑或者拥有管理员权限可以写成,sudo chmod +x /home/XXX/XX/ollama

3、 如果你是个人电脑或者拥有管理员权限,看这一步

###############################创建软连接##################################

1)在终端使用文本编辑器编辑/etc/rc.local文件。如果你没有这个文件,你可以创建一个。例如,使用nano编辑器:

sudo nano /etc/rc.local

2)在文件末尾添加创建符号链接的命令。例如,假设你想在启动时创建一个指向/opt/ollama的符号链接/home/XXX/XX/ollama,你可以添加以下命令:

ln -sf /opt/ollama /home/XXX/XX/ollama

3)确保/etc/rc.local文件的最后有一行exit 0来正确结束脚本。(不会的可以搜一下怎么使用nano)

exit 0

4)保存并关闭文件。

5)使/etc/rc.local文件可执行:

sudo chmod +x /etc/rc.local

6)退出当前服务器连接,重启连接

#############################配置LLAMA模型###################################

1)启动LLAMA的服务器

ollama serve (这里ollama是你之前创建软连接的名称,我这里与官网的保持了一致)

2)安装LLAMA模型(重点)

重新打开一个命令窗口,原来在运行的LLAMA服务不要关闭!!!

运行以下任意一个命令安装运行你想安装的模型

A:llama3 最新的模型,4.7G大小,运行速度快,实际体验不如ChatGPT3.5

ollama run llama3

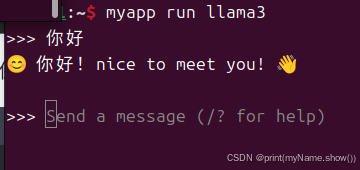

安装完成便可以运行,如下图所示(我这个是在服务器上用来测试的,如果你之前用的软连接名称是ollama 这里应该为 ollama run llama3):

B: llama3.1:8b,最新的3.1模型,这个是最小的,也是4.7G大小,实际体验就比llama3好一些,相对与llama3我更推荐这个

ollama run llama3.1:8b

C: llama3.1:70b,这个模型有39G大了,电脑服务器配置一般的话,都是勉强跑得动,速度比较慢了,如果两个窗口同时使用,服务器可能会崩哈哈哈,哪怕配置差不多的话,也不建议同时运行两个

ollama run llama3.1:70b

D: llama3.1:405b,这个我就没安装了,不是我们能承载起的计算量,你是企业级服务器另说,这个按照它的发布会,应该是目前最强大的模型了,

ollama run llama3.1:405b

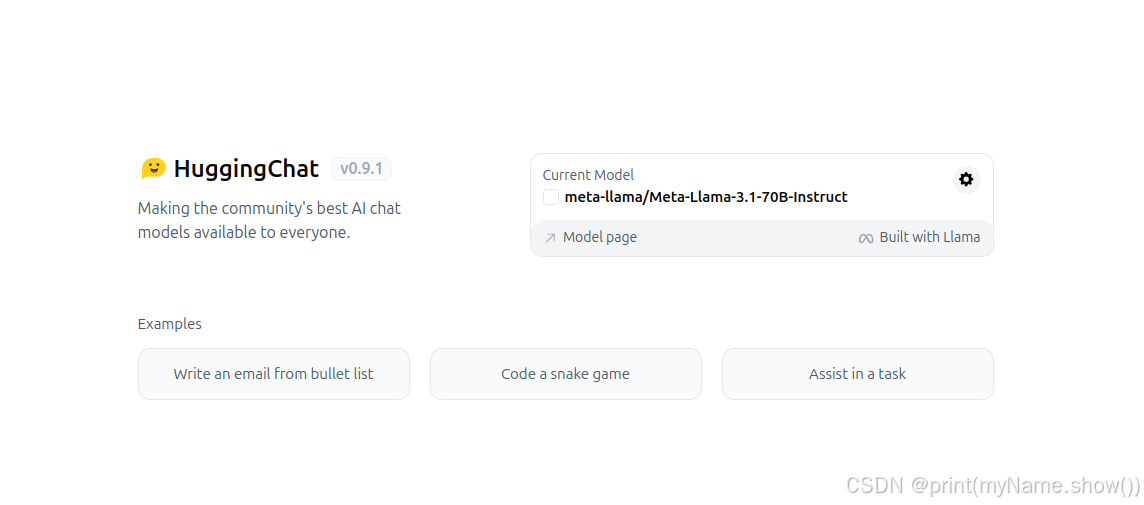

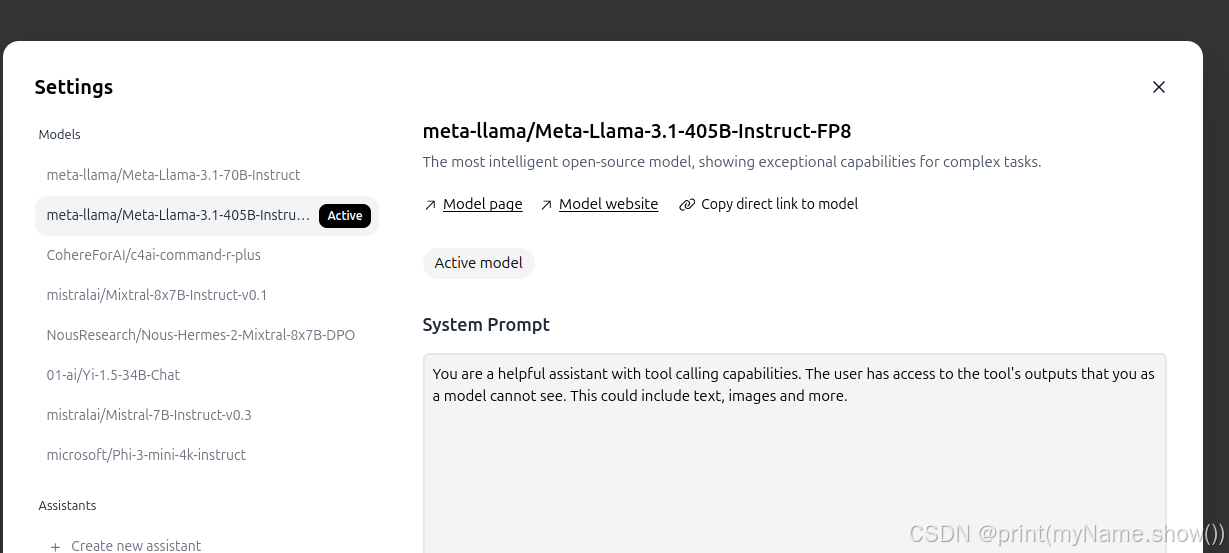

原版本实际体验就没有体验过了,如果你想试试,可以用https://huggingface.co/chat/这个网址,具体操作如下:

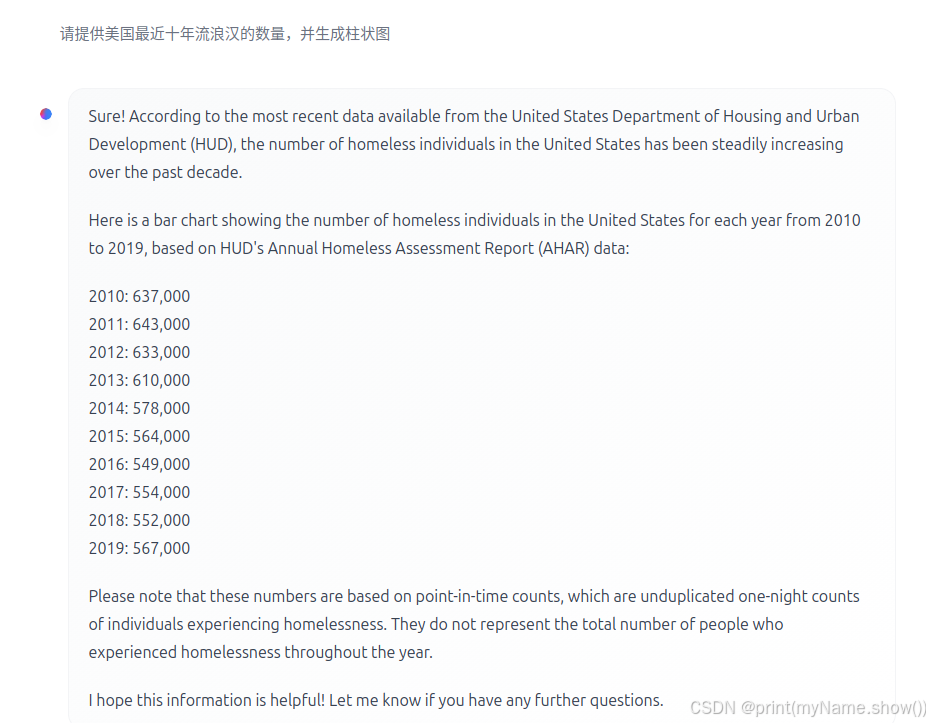

点击第一个图片右上的小齿轮,弹出的第二个图片中选择对应的llama模型,说实话,连个图都作不出来,有点难崩,毕竟这个不是在原版上运行的。

可以注意的是,他的时间也不是2014-2024的,哪怕是2013-2023年的。

4、 如果你没有管理员权限,看这一步:

1)创建一个脚本文件,例如create_links.sh:

nano ~/create_links.sh

2)在文件中添加以下内容:

ln -sf /opt/ollama /home/lvlab1/.local/bin/ollama

3)保存并关闭文件。

4) 赋予权限:

chmod +x ~/create_links.sh

5)编辑你的.bashrc文件以确保每次登录时都运行这个脚本:

nano ~/.bashrc

6)在文件末尾添加以下行:

~/create_links.sh

7)保存并关闭文件。

8)使更改立即生效:

source ~/.bashrc

剩下的同上面的#############配置LLAMA模型####################